World Model Theory

一直以来,一个问题困扰着我和许多的AI研究者,那就是:“Is learning necessary?”。更具体一点,我们可以这样表述这个问题:要实现AGI,基于概率的机器学习和深度学习真的是必须的吗?我们能通过ML和DL实现真正的智能吗?

对于这个问题,受到世界模型理论的启发和LLM在近年来出众表现的激励,经过长久的思考,我得到了一个答案:AGI是可以通过我们现有的基于概率的模型来实现的。

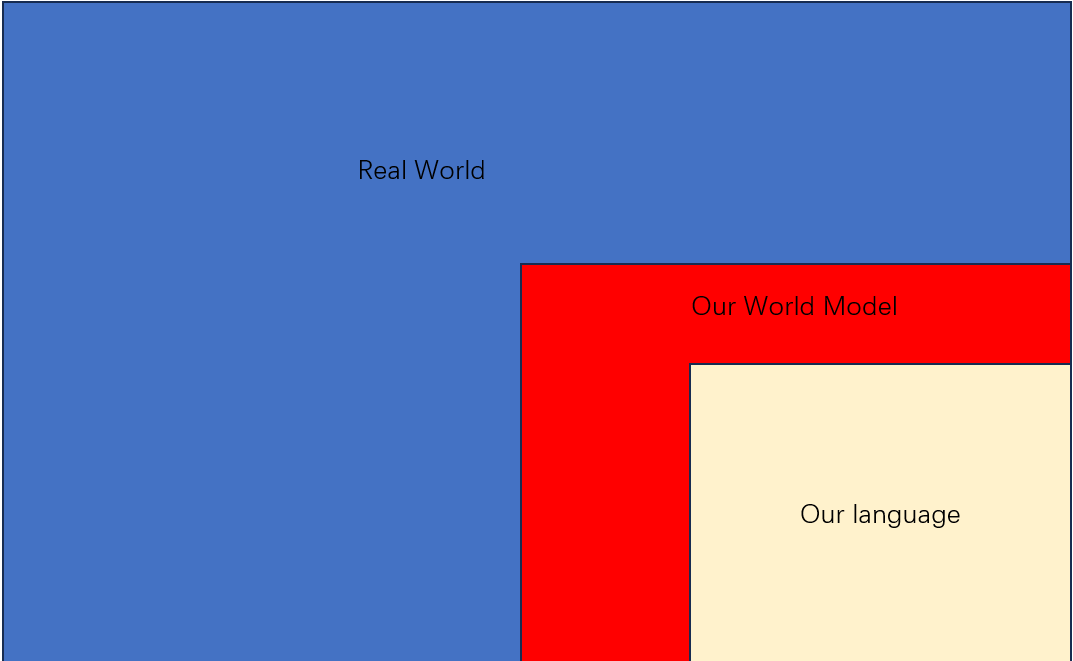

首先是LLM的这类自回归语言模型的成功。我们可以看到LLM是具有相当的语言理解能力的,这可以归功于其是在大规模语料数据集上做过预训练。但是让人惊讶的是,他们似乎同样对这个世界有一些了解(GPT4可以理解位置关系、LLM可以使用API作为工具)。当我了解到这一点时,我感到非常的迷惑。训练是在自然语言构成的数据集上进行的,那么LLM的假设集应当是语义空间(对人类有意义的语句和词汇之间的映射关系的集合)的子集。但是事实并非如此,LLM学习到了部分真实世界的运作规律(同时我认为这才是其泛化能力来源的关键)。虽然仅仅是部分的不完全的规律,但是这仍然这远远超出了语义空间的范畴。LLM在语句上做训练,那么理论上它应当只会学习到词语之间的对应关系。但是LLM从这些数据中总结出了一部分世界的运行规律。这正说明了我们的语言在某种程度上是一种对世界的运行规律的客观总结。更学术的说法是,语言是我们脑中的世界模型运行的结果。

世界模型的理论(最初由Jürgen Schmidhuber提出,但是LeCun这几年在这方面的进展较多)可以对在LLM中的这些奇怪的情况做出相当合理的解释。世界模型理论认为:我们的大脑针对我们所观察到的现实世界总结了一个世界模型,当我们基于我们的记忆和直觉做出各种推理和预测时,我们实际上是在使用我们的世界模型进行搜索和外推。从这个角度来看,甚至可以说我们的意识运行在我们各自的世界模型上。对世界模型的一个更数学一点的解释是,一个关于真实世界运行规律的分布的拟合。

套用世界模型的理论来解释上面给出的例子,我们的可以说由于语言是世界模型运行得到的一个结果,所以每次仅能反应一部分我们脑中的世界模型中的信息,而LLM又从我们的语言中学习到了这一部分世界模型。又因为LLM仅学习到了我们部分的世界模型,所以仅能在某些特定情况下做的很好(如改写,辨别方位,理解简单的逻辑顺序),而在另一些事情上做得很差(如A is B,B is A问题)。LLM并不能完全正确的反应我们自己的世界模型,更难以直接反应真实世界的运行规律。但是从这个角度来讲,假如我们的模型产生了一个完整的世界模型,我们就真的得到AGI了。

因此我认为,既然LLM是从语言上采样并学习即可得到了一部分我们的世界模型,那我们何不直接在真实世界中采样来使得我们的模型获得自己的世界模型?在语料上训练得到的世界模型只能是人类世界模型的子集,要使得模型得到一个和人类同等规模或者超远人类的世界模型,我们必须让我们的模型在整个真实世界中采样。

此时的模型已经不是在单纯在语言上进行训练,而是要在各种模态的信息上进行训练(我认为这似乎是GPT4-V的强大能力的根源)。如果我们能够使得我们的模型足够大且我们对真实世界做了足够多有效的采样(感谢大数定律,可以保证此时采样得到的数据反应了真实的世界的规律),那么从LLM仅在语料上训练就可以得到少部分世界模型这一点来看,只要有合理的训练方法(目前缺少这些方法),那么毫无疑问的,我们就可以使得我们的模型产生世界模型,可以使得AGI真正的出现。而我认为在当今的AI研究人员的努力下,训练、数据和模型架构上的难题都将迅速的得到解决。

所以毫无疑问的,AGI将很快就会出现。